خطرات کنونی هوش مصنوعی و راههای مقابله با آن

به گزارش اقتصاد نیوز و به نقل از زومیت، چگونه میتوان از خطرات همزمان هوش مصنوعی، رباتها و شرکتهای بزرگ فناوری پیشگیری کرد؟

اگر اخبار مربوطبه هوش مصنوعی را دنبال کنید، میدانید که نگرانیها در مورد آینده دستگاهها و رباتهای فوق هوشمند رو به افزایش است. بررسیهای سال گذشته نشان داد که هوش مصنوعی زودتر از زمانیکه پیشبینی شده است، میتواند به فناوری خطرناکی تبدیل شود.

جدیدترین پیشرفتهای هوش مصنوعی باعث شده است این فناوری انقلابی در انجام کارهای بصری مثل دستهبندی تصاویر و تبدیل گفتار به نوشتار عملکرد بسیار خوبی داشته باشد؛ البته هیجان و خوشحالی ناشی از ایجاد این تواناییهای شگفتانگیز در هوش مصنوعی ما را از معایب آن غافل کرده است؛ هوش مصنوعی هنوز راه زیادی برای رسیدن به هوش و استعداد بشر دارد و همین موضوع میتواند در آیندهای نهچندان دور (یا بهتر است بگوییم همین زمان کنونی) پیامدهای خطرناکی را بهدنبال داشته باشد؛ زیرا امکان دارد الگوریتمهای هوش مصنوعی اتفاقهای غیرقابل انتظاری را رقم بزنند یا دقت نکردن در استفاده از آنها میتواند عواقب بدی داشته باشد.

در ادامه ۶ مورد از خطرات حالحاضر استفاده از هوش مصنوعی در زمینههای خودروهای خودران، ایجاد بات های مخرب و شبکههای عصبی، فناوریهای نظامی، فناوری تشخیص چهره، فناوریهای مرتبط با شناسایی افراد و همچنین استفادهی غیر اخلاقی از هوش مصنوعی را بیان میکنیم و سپس در هر بخش به ارائهی راهکارهایی برای مقابله با این خطرات میپردازیم. این بررسی به دست پژوهشگران دانشگاه MIT صورت پذیرفته است.

خودروهای خودران

پس از تصادف خودروهای خودران اوبر در ماه مارس سال گذشته، پژوهشگران دریافتند که فناوری این شرکت بهصورت فاجعهباری شکست خورده است؛ اما مسئولان آن میتوانستند با روشی ساده مانع این شکست شوند.

مشکل بزرگ خودروهای خودران این است که شرکتهای خودروساز مطرح مانند فورد و جنرال موتورز، شرکتهای تازهکاری مانند اوبر و چند استارتآپ دیگر قصد دارند هرچه زودتر این فناوری تجاریسازی و بهصورت گسترده استفاده شود؛ اما این دستاورد بزرگ برخلاف سرمایهی هنگفت چند میلیارد دلاری که برای آن صرف شده، هنوز به تکامل کامل نرسیده است. وِیمو (Waymo)، یکی از شرکتهای تابعهی آلفابت (Alphabet، هلدینگی در کالیفرنیا کهگوگل یکی از زیرمجموعههای آن است)، بیشترین پیشرفت را در این فناوری ایجاد کرده است و سال گذشته نخستین تاکسیهای کاملا مستقل خود را در ایالت آریزونا راهاندازی کرد؛ اما حتی تاکسیهای این شرکت هم محدویتهایی داشتند و نمیتوانستند در همه جهات بدون مشکل حرکت کنند.

تاکسیهای خودران ویمو

تدابیر درنظر گرفتهشده برای این فناوری در سال ۲۰۱۹:قانونگذاران آمریکایی تصمیم گرفتهاند، برای کاهش نگرانیها و ترسها درمورد این فناوری، در تصمیمگیریهای و اعمال قوانین مختلف، از نظرات و پیشنهادهای مردم استفاده کنند. ادارهی ملی مدیریت امنیت ترافیک بزرگراههای آمریکا (National Highway Traffic Safety Administration) تاحدودی موافق کاهش قوانین موجود سختگیرانهی امنیتی است؛ اما رانندگان سایر خودروها و عابران پیاده نمیخواهند در آزمایش این فناوری همچون موش آزمایشگاهی باشند؛ البته درصورتیکه در سال ۲۰۱۹ باز هم این خودروها تصادف بدی داشته باشند، ممکن است نگرش قانونگذاران تغییر کند.

باتهای مورداستفاده برای اهداف سیاسی

در ماه مارس سال گذشته، اخبار مربوطبه سوءاستفادهی شرکت کمبریج آنالیتیکا (Cambridge Analytica)، یک شرکت مشاورهدهندهی سیاسی، از فعالیتهای مرتبطبا بهاشتراکگذاری فیسبوک برای تحتتاثیر قرار دادن نتیجهی انتخابات ۲۰۱۶ آمریکا منتشر شد. این خبر سروصدای زیادی به پا کرد و نشان داد که چگونه الگوریتمهای هوش مصنوعی میتواند نوع اخبار و اطلاعات درحال جستوجو در شبکههای اجتماعی را تحتتاثیر قرار دهد و ممکن است این توانایی هوش مصنوعی منجر به افزایش اطلاعات نادرست، لطمه زدن به مباحث سالم و منزوی کردن مردم و ایجاد اختلافنظر در میان آنها شود.

مارک زاکربرگ، مدیرعامل فیسبوک، در یکی از جلسههای کنگرهی آمریکا مدعی شد که هوش مصنوعی در آینده میتواند محتواهای بد و مخرب را شناسایی و مسدود کند؛ البته وی متذکر شد که هوش تا تشخیص معنا و مفهوم ظاهری یا حقیقی متون، تصاویر و ویدیوها فاصله زیادی دارد.

تدابیر درنظر گرفتهشده برای این فناوری در سال ۲۰۱۹: ظاهرا قرار است وعدهی زاکربرگ در مورد توانایی هوش مصنوعی برای شناسایی و حذف محتواهای مخرب در انتخابات پیشروی دو کشور بزرگ آفریقایی یعنی آفریقای جنوبی و نیجریه، آزمایش شود و بررسی بلندمدت این توانایی برای بهکارگیری آن در انتخابات ۲۰۲۰ آمریکا نیز آغاز شده است؛ البته نباید فراموش کنیم که این فناوری میتواند زمینه را برای ایجاد فناوریهای مبتنی برپایه هوش مصنوعی برای گسترش اطلاعات نادرست مانند رباتهای چت مخرب فراهم کند.

استفادهی نظامی خطرناک از هوش مصنوعی

سال گذشته تعدادی از کارمندان گوگل مطلع شدند که کارفرمایان آنها فناوری خاصی برای دستهبندی شیوه تصویربرداری با پهپاد، در اختیار ارتش آمریکا قرار دادهاند و پس از آن جنبشی بر مبنای استفاده از هوش مصنوعی برای گسترش صلح و آشتی شکل گرفت. کارمندان گوگل نگران بودند که این اقدام کارفرمایان آنها میتواند به ارائهی فناوری فاجعهباری برای آغاز حملات پهپادهای مرگبار و درنتیجه به خطر افتادن جامعهی بشریت ختم شود. گوگل درواکنش به این جنبش از پروژهی مِیوِن (Project Maven) که براساس آن نرمافزارهای هوش مصنوعی گوگل در اختیار ارتش آمریکا قرار میگرفت، خودداری کرد و پس از آن یک کد هوش مصنوعی برای موارد اخلاقی ایجاد شد.

نهادهای بسیار مطرح صنعتی و آموزشی کمپینی برای ممنوعیت استفاده از سلاحهای مستقل ایجاد و از آن حمایت کردند. استفادهی نظامی از هوش مصنوعی بهتازگی آغاز شده است و بهنظر میرسد که در آینده شدیدا با آن مقابله خواهد شد. درضمن پس از قطع همکاری گوگل با ارتش آمریکا، شرکتهای بزرگ فناوری دیگر مثل مایکروسافت وآمازون هم حاضر به مشارکت در این اقدام غیرانسانی نشدهاند.

سلاحهای مستقل خطر بزرگی برای بشریت هستند

تدابیر درنظر گرفتهشده برای این فناوری در سال ۲۰۱۹: اگرچه سرمایهگذاری پنتاگون برای استفاده از هوش مصنوعی در حال افزایش است، اما فعالان حقوقبشر امیدوارند پیمان ممنوعیت استفاده از سلاحهای مستقل که دربرخی از جلسههای سازمان ملل در حال بررسی است، در سال میلادی جاری اجرا شود تا این سلاحها تهدیدی بزرگ برای بشر نباشند.

فناوری تشخیص چهرهی هوش مصنوعی برای نظارت بر افراد

فناوری تشخیص چهرهی هوش مصنوعی امکان استفادهی قابلتوجه از فناوریهای نظارتی برای مقامات مسئول کشورهای مختلف را فراهم میکند. از فناوری تشخیص چهره میتوان برای باز کردن قفل گوشیها و تگ شدن خودکار شما در تصاویر در شبکههای اجتماعی نیز استفاده کرد.

گروههای آزادیخواه مدنی هشدار دادهاند که استفاده از این فناوری ممکن است ایجاد دو دستگی در جامعه را به همراه داشته باشد. فناوری تشخیص چهره میتواند راه را برای تجاوز به حریم خصوصی باز کند و چنانچه افراد متعصب در ارائهی دادهها به هوش مصنوعی دست داشته باشند، زمینه تبعیض خودبهخود فراهم میشود.

درحالحاضر در بسیاری از کشورها (بهخصوص چین)، بهصورت گستردهای از هوش مصنوعی برای نظارت دولت و پلیس بر مردم استفاده میشود و آمازون نیز در حال فروختن این فناوری به سازمانهای مهاجرت و قانونگذار آمریکا است.

تدابیر درنظر گرفتهشده برای این فناوری در سال ۲۰۱۹: در آینده فناوری تشخیص چهره در وسایلنقلیه و وبکمها هم نیز مورد استفاده قرار خواهد گرفت و علاوهبر شناسایی صورت افراد، حرکت آنها نیز کنترل خواهد شد؛ اما امسال قوانینی برای کنترل استفاده از آن وضع خواهد شد.

استفاده از الگوریتم هوش مصنوعی برای ساخت فیلمهای جعلی

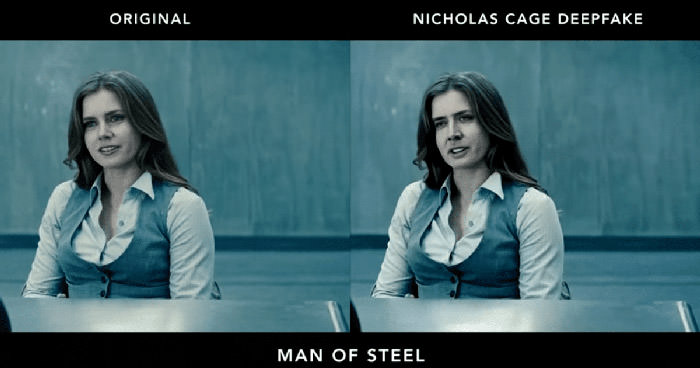

تصویر سمت چپ واقعی و تصویر سمت راست ساختگی است

همهی ما میدانیم تعداد فیلمها و تصاویر جعلی که کاملا واقعی بهنظر میرسند، تعدادی از آنها هم بهسرعت در شبکههای اجتماعی منتشر میشود، بهطور فزایندهای درحال افزایش است. برخی از این فیلمها مثل فیلمهای مبتذل افراد مشهور، فیلمهای عجیب و غریب، فیلمهای سیاسی و سایر موارد، با استفاده از هوش مصنوعی ساخته میشوند.

تصویر سمت چپ واقعی و تصویر سمت راست ساختگی است

شبکه های عصبی مولد (Generative adversarial networks یا GANs) که نوعی هوش مصنوعی مورداستفاده در یادگیری ماشین بهشمار میرود و از دو شبکهی عصبی درگیر با یکدیگر تشکیل میشود، قادر است تصاویر و ویدیوهایی را نمایش دهد که به طرز شگفتانگیزی واقعی بهنظر میرسند، اما کاملا ساختگی هستند. شرکت انویدیااخیرا توانایی شبکههای عصبی مولد در ساخت تصاویر واقعگرایانه از صورت افرادی با نژاد، جنسیت و سن مختلف را ثابت کرده است.

تدابیر درنظر گرفتهشده برای این فناوری در سال ۲۰۱۹: با افزایش فیلمهای جعلی و ساختگی که کاملا واقعی به نظر میرسد، مردم هم بیشتر فریب میخورند. مسئولان سازمان پروژههای تحقیقاتی پیشرفتهی دفاعی (DARPA) قصد دارد برای تشخیص اینگونه فیلمها، روشهای جدیدی را مورد بررسی قرار دهند؛ اما بهدلیل اینکه این روشها نیز بر پایهی هوش مصنوعی ایجاد شدهاند، استفاده از آنها برای تشخیص فیلمهای ساختهشده با هوش مصنوعی، درست مانند بازی موش و گربه است.

الگوریتمهای ایجادکنندهی تبعیض

سال گذشته تعصبات بیجا در الگوریتمهای ابزار تجاری مختلف متعدد مورداستفاده برای تشخیص افراد، به شکلهای مختلفی کرد پیدا کرد. آن دسته از الگوریتمهای بصری ایجاد شده در دستگاههای تشخیص افراد که برپایهی دادههای نامتوازن شکل گرفتهاند، در تشخیص زنان یا افراد رنگین پوست با مشکل مواجه میشوند.

استفاده از نرمافزارهایی که باعث ایجاد دادهها در دورههای زمانی مختلف میشوند، تبعیض را به معضلی همیشگی و ادامهدار تبدیل میکند.

تدابیر درنظر گرفتهشده برای این فناوری در سال ۲۰۱۹: در سال جاری روشهایی برای تشخیص و کاهش تعصبات بیجا در نظر گرفته شده و همچنین الگوریتمهایی جهت ایجاد نتایج غیرمتعصبانه از نتایج متعصبانه ایجاد شده است. در کنفرانس بینالمللی یادگیری ماشینی (The International Conference on machine learning)، یکی از کنفرانسهای مطرح در زمینهی هوش مصنوعی، در سال ۲۰۲۰ در کشور اتیوپی برگزار میشود؛ زیرا برخی از پژوهشگران آفریقایی که درمورد مشکلات مرتبطبا تعصبات بیجا پژوهش میکنند، ممکن است برای اخذ ویزای سایر مناطق با مشکل مواجه شوند؛ به همین دلیل چنین رویداد مهمی هم باید در کشوری آفریقایی برگزار شود.